Comment créer un chatbot doté d'une intelligence artificielle.

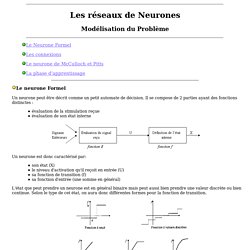

MATLAB pour le Deep Learning. Kohonen som. Les reseaux de neurones Modélisation. Un neurone est donc caractérisé par: son état (X) le niveau d'activation qu'il reçoit en entrée (U) sa fonction de transition (f) sa fonction d'entrée (une somme en général) L'état que peut prendre un neurone est en général binaire mais peut aussi bien prendre une valeur discrète ou bien continue.

Selon le type de cet état, on aura donc différentes formes pour la fonction de transition. Les Réseaux de Neurones. L'Architecture du Réseau Le recuit simulé Le principe général Les Algorithmes Les Résultats Le réseau de Boltzmann a été introduite en 1984 par Ackley, Seijnowski et Hinton.

Les reseaux de neurones fondements. Structure des neurones On pense que le système nerveux compte plus de 1000 milliards de neurones interconnectés.

Bien que les neurones ne soient pas tous identiques, leur forme et certaines caractéristiques permettent de les répartir en quelques grandes classes. En effet, il est aussi important de savoir, que les neurones n'ont pas tous un comportement similaire en fonction de leur position dans le cerveau. Avant de rentrer plus en avant dans les détails, examinons un neurone. On peut le décomposer en trois régions principales: Le corps cellulaire. Les réseaux de neurones convolutifs. Si vous avez bien saisie la notion de convolution et le principe de fonctionnement des MPL, vous remarquerez que la convolution à pour avantage de n’avoir que quelques poids à calculer(ceux du filtre) et qu’elle les réutilises pour l’ensemble de l’image, tandis que les MLP vont avoir un poids unique à calculer pour chaque neurone.

Cela réduit encore considérablement le nombre de calculs. Pour simplifier l’explication du processus de la couche de convolution, je n’ai parlé que d’image et de carte de caractéristiques en 2D. Focus : Le Réseau de Neurones Convolutifs. L’une des capacités fondamentales de l’humain est celle d’analyser son environnement.

Dans la majorité des cas, cela passe par la reconnaissance des éléments de notre champ de vision : trouver les autres personnes, identifier les voitures, les animaux… Jusqu’à l’émergence des réseaux de neurones convolutifs, en 2012 avec Alex Krizhevsky, la tâche était difficile pour un ordinateur. Heureusement, l’approche de ces réseaux inspirés de notre oeil (plus particulièrement du fait que certains neurones de notre aire visuelle ne réagissent qu’aux bordures verticales et d’autres aux horizontales/diagonales) a ouvert de nombreuses applications, que ce soit en imagerie médicale, véhicules autonomes, reconnaissance faciale, et même analyse de textes. Dans ce focus, nous allons voir ce qu’est un réseau neuronal convolutif puis nous en implémenterons un ensemble !

Comment les Réseaux de neurones récurrents et Long Short-Term Memory fonctionnent. Traduit de la vidéo originale de Brandon Rohrer (Senior Data Scientist à Facebook), “How Recurrent Neural Networks and Long Short-Term Memory Work” Les applications d’apprentissage automatique ont gagné beaucoup de traction depuis quelques années et ce dans plusieurs catégories: Dans l’identification d’images, ou comment identifier une image sur internet comme contenant un chat par exemple, ou similaire;Dans la conversion/traduction séquence à séquence, ou comment convertir la parole en un texte et comment passer d’une langue à une autre; Les premiers sont réalisés la plupart du temps avec des réseaux neuronaux convolutionnels (dont nous avons déjà parlé dans un article précédent: “Comment les Réseaux de neurones à convolution fonctionnent”), et les seconds sont realisés avec des réseaux de neurones récurrents, dont en particulier les Long Short-Term Memory — LSTMs — (donc nous allons discuter maintenant).

Les LSTMs et les problèmes qu’ils résolvent. Comment les Réseaux de neurones à convolution fonctionnent. Traduction de l’article original de Brandon Rohrer (Senior Data Scientist à Facebook), “How Convolutional Neural Networks Work” Neuf fois sur dix, quand vous entendez parler des barrières scientifiques qui ont été repoussées grâce à l’application de techniques d’Apprentissage profond (ou Deep Learning en anglais), les réseaux de neurones à convolution sont impliqués.

Aussi appelés CNN ou ConvNets, ils constituent les fers de lance de l’Apprentissage profond. Aujourd’hui, ils sont même capable d’apprendre à trier des images par catégorie avec dans certains cas, de meilleurs résultats qu’après un triage manuel. S’il y a donc aujourd’hui une méthode qui justifie un engouement particulier, il s’agit donc bien des CNNs. Ce qui est particulièrement intéressant avec les CNNs, c’est qu’ils sont également faciles à comprendre, lorsque vous les divisez en leurs fonctionnalités de base. Les reseaux de neurones artificiels. Réseau de neurones artificiels : qu'est-ce que c'est et à quoi ça sert ?

Un réseau de neurones artificiels ou Neural Network est un système informatique s’inspirant du fonctionnement du cerveau humain pour apprendre.

Découvrez tout ce que vous devez savoir sur cette technologie d’intelligence artificielle de la famille du Deep Learning. En 2019, l’intelligence artificielle est sous le feu des projecteurs. Cette technologie se développe à grande vitesse, et ses cas d’usage se multiplient dans tous les secteurs. Gradient boosting. Blog bioinformatique communautaire scientifique. Bonjour à tous et soyez les bienvenus dans ce 3ème cours de R pour débutant pressé.

Aujourd’hui, nous allons voir rapidement ce qu’est une régression (linéaire ou quadratique), à quoi ça sert et ce que ça peut nous apprendre sur nos données. Ne vous êtes-vous jamais demandé comment en apprendre plus sur vos données, comment savoir quel paramètre est le plus important ou plus simplement s’il est possible « de faire une belle ligne sur mon graphique » ? Non ? Ah… et bien merci à bientôt. Régressions linéaires.

Lorsque la variable à expliquer est quantitative continue, le modèle statistique adapté est la régression linéaireLorsqu’il n’existe qu’une seule variable explicative et qu’elle est qualitative, la régression linéaire donne un résultat proche d’un test T de Welch ou de Student Dans un effort de simplification, nous appellerons Y la variable que l’on souhaite expliquer par des facteurs X.

(Faites appel à vos lointains souvenirs : Y = aX +b) Par exemple, si on souhaite expliquer la taille d’un enfant en fonction de la taille de sa mère, Y est la taille de l’enfant et X la taille de la mère. A quoi ça sert. St l inf regsim. Bagging boosting. Bagging boosting. Naive Bayes Classifier pour la Classification en Machine Learning. St m app agreg. Gradient boosting. Best AI Platforms Software in 2019. (54) Machine Learnia. (54) Thibault Neveu. Education. Resources. Guidebook materials Exercises for cross-functional team members to help guide key discussions, expedite design iteration, plan for user research, and set effective AI development timelines, along with guidebook chapters in easily printable pdfs. Tencent Open-Sourced Algorithm Betters Face Detection Benchmarks.

Chinese technology giant Tencent has open-sourced its face detection algorithm DSFD (Dual Shot Face Detector). The related paper DSFD: Dual Shot Face Detector achieves state-of-the-art performance on WIDER FACE and FDDB dataset benchmarks, and has been accepted by top computer vision conference CVPR 2019. Face detection is a fundamental step for facial alignment, parsing, recognition, and verification. (11) Normalisation des données - Se former à Tensorflow 2.0 #6. Formation à TensorFlow 2.0. Profitez de plus de 5h de formation vidéo gratuite à TensorFlow 2.0, l’un des frameworks de Deep Learning les plus puissants en matière d’intelligence artificielle. Thibault Neveu, chercheur en intelligence artificielle et contributeur expert Actu IA propose une nouvelle série de vidéos d’initiation au Deep Learning.

Cette série est consacrée à la formation à TensorFlow 2.0. Que vous soyez débutant sous TensorFlow ou que vous souhaitiez simplement découvrir les nouveautés de cette nouvelle version. Retrouvez plus de 5H de vidéo de formation gratuite découpée en 22 vidéos, soit des dizaines d’heures d’expérimentation vous guidant sur le chemin de l’autonomie en matière de Deep Learning. Hacker les modèles de Deep Learning facilement. Introduction Les réseaux de neurones profonds, en abrégé, DNNs (Deep Neural Networks) sont les modèles d’apprentissage les plus performants ayant plusieurs cas d’usage, notamment dans de nombreux environnements critiques tels que les voitures autonomes, le diagnostic du cancer, la surveillance et le contrôle d’accès, les assistants personnels intelligents, le credit scoring, la détection de transaction financière frauduleuse et des fichiers binaires malveillants. Cependant, des recherches scientifiques montrent que ces modèles sont facilement dupés.

Nous distinguons différents types d’attaques qui peuvent tromper les DNNs (pour plus de détails, voir la section Classement des attaques adverses): Algorithmes d’attaque adverse Les algorithmes d’attaque adverse représentent le type le plus étudié, et le premier qui a été introduit. Thibault Neveu, chercheur en IA, propose une série de vidéos d'initiation au Deep Learning. AutoDraw. Créez votre compte gratuit Azure dès aujourd’hui. Créez votre compte gratuit Azure dès aujourd’hui. Reconnaissance d’entités biomédicales - Team Data Science Process - Azure Machine Learning. Qu'est-ce que Azure Machine Learning ? DeepLab disponible au sein du framework Tensorflow en open source. Google Research a annoncé la mise en disposition en open source sur GitHub de sa technologie DeepLab-v3+ au sein de son framework TensorFlow.

Développée à partir de réseaux de neurones convolutifs, elle sera désormais accessible aux développeurs. DeepLab est un modèle de segmentation sémantique d’images qui a été utilisé dans la création des modes ‘portrait’ des smartphones Pixel2 et Pixel 2 XL. Cette technologie développée par Google permet d’assigner une étiquette d’identification à chaque pixel d’une image contenant des éléments tels que le ciel, un chien ou encore une personne. Les applications de cette technologie sont donc multiples car elle peut par exemple être utilisée pour identifier une personne, la détourer ou flouter le reste de l’image afin de simuler une photo prise sur un appareil doté d’une grande ouverture, capable de produire un effet bokeh.

“Cet étiquetage sémantique nécessite d’identifier le contour des objets”, explique Google Research sur son blog. Google donne accès à l'Intelligence Artificielle sans avoir à coder. Watson mène la révolution de l’intelligence artificielle. AlphaGo Zero: Learning from scratch. It is able to do this by using a novel form of reinforcement learning, in which AlphaGo Zero becomes its own teacher. Les conséquences pratiques d’AlphaGo Zero. Dans l'IA, la guerre des Gafa se fait à grands coups d'open source. A list of artificial intelligence tools you can use today — for businesses (2/3) continued. Conversational Interfaces & Chatbots. A list of artificial intelligence tools you can use today — for businesses (2/3) A list of artificial intelligence tools you can use today — for industry specific (3/3) A list of artificial intelligence tools you can use today — for personal use (1/3) Watson : comment les solutions cognitives d'IBM répondent à l'évolution de l'informatique, entretien avec Philippe Comte d'IBM France.

IBM Cognitive Business Solutions. IBM: Cognitive Bank. The Many Editions of IBM Watson Analytics. DeepCoder, l'IA qui code en s'inspirant d'autres logiciels - Tech. 5 stars de la robotique open source pour tous vos projets. L'intelligence artificielle de Deepmind (Google) apprend en se souvenant. Intelligence artificielle : Google DeepMind se dote d’une unité de recherche sur l’éthique. Rentrez dans l'univers du Watson Summit Paris 2017 - Technologie. Microsoft AI Factory : 7 start-ups pour construire une communauté de l’IA au cœur de Station F - Hub Presse Microsoft France. A la rencontre de Watson, l’intelligence artificielle star d’IBM.

La nouvelle IA de Google, AlphaGo Zero, a battu AlphaGo 100-0. L'intelligence artificielle de Google peut désormais créer sa propre IA. AT&T lance un projet Open Source d'intelligence artificielle. Baidu/Deep Voice apprend à parler en quelques heures seulement ! – Intelligence Artifcielle, Robotique et Big Data.